Actualités philosophiques, scientifiques et sociétales

Un Chacun par Pieter Brueghel l'Ancien

- Détails

- Écrit par : Patrick Juignet

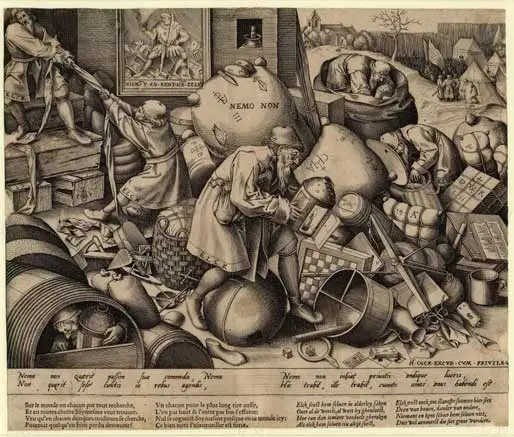

Sur cette gravure de 1566, on voit des hommes cherchant, au milieu d'une foule d'objets hétéroclites, la lanterne qui les éclairera. L'un d'eux l'ayant trouvée enjambe sans s'y intéresser le globe terrestre et un autre la garde précieusement tout en restant caché dans un tonneau. D'autres personnages se disputent sottement une couverture.

La Physique selon Pierre Duhem

- Détails

- Écrit par : Patrick Juignet

Dans La Théorie physique, son objet, sa structure (1906), L'auteur écrit :

« En regardant la théorie physique comme une explication hypothétique de la réalité matérielle, on la place sous la dépendance de la Métaphysique. [...] Ne pourrait-on assigner à la physique un objet tel qu'elle devint autonome ? (p. 25).

Pierre Duhem propose alors la définition suivante :

« Une théorie physique n'est pas une explication. C'est un système de propositions mathématiques, déduites d'un petit nombre de principes, qui ont pour but de représenter aussi simplement, aussi complètement et aussi exactement que possible, un ensemble de lois expérimentales (p. 26). L'accord avec l'expérience est, pour une théorie physique l'unique criterium de vérité (p. 28).

Cependant il y a un problème :

« Une théorie physique ne peut se souder aux faits observables que par une traduction...qui remplace le langage de l'observation par le langage des nombres (p. 215).

Il faut donc considérer la transformation des faits en des abstractions pouvant être théorisées :

« Une expérience de Physique est l'observation précise d'un groupe de phénomènes, accompagnée de l'interprétation de ces phénomènes ; cette interprétation substitue aux données concrètes réellement recueillies par l'observation des représentations abstraites et symboliques qui leur correspondent en vertu des théories que l'observateur admet » (p. 238).

Duhem P., La Théorie physique, son objet, sa structure, Paris, Chevalier et Rivière, 1906.

Cerveau reptilien

- Détails

- Écrit par : Patrick Juignet

La vulgarisation aboutit assez souvent à des savoirs distincts et nettement différents du savoir d’origine.

Dans le domaine des neurosciences, qui a bénéficié de la mode des idéologies biologisantes en France depuis les années 1970, la théorie du cerveau reptilien s’est largement répandue. Partant d’un cadre général, présenté dans Le Singe, le gène et le neurone (2013), la théorie selon laquelle l’Homme aurait une partie de son cerveau du même type que celui des reptiles s’est répandue.

Le « cerveau reptilien » est un concept censé expliquer nos comportements primitifs – des besoins les plus élémentaires comme s’alimenter ou se reproduire jusqu’à nos pulsions les plus violentes. Il n’est pas rare de voir le terme utilisé dans les ouvrages de développement personnel, par des publicitaires se targuant de cibler la part reptilienne de notre cerveau pour vendre leurs produits, ou encore par de pseudo-thérapeutes qui souhaitent nous aider à apprivoiser le « crocodile en nous ».

La notion de cerveau reptilien s’inscrit plus largement dans la théorie du « cerveau triunique » développé par le neurobiologiste Paul MacLean dans les années 1960. Cette théorie générale de l’organisation du cerveau rapporte à une part archaïque de notre héritage évolutif un ensemble d’attitudes « primaires », par exemple l’instinct sexuel, l’instinct de survie, l’agressivité. Plus précisément, le cerveau humain tel qu’il est aujourd’hui serait, selon cette théorie, composé de trois « couches ». Chacune se serait développée à des moments différents, et correspondrait à une étape de l’évolution de l’espèce humaine. Chacune contrôlerait un aspect spécifique de nos comportements. La plus ancienne de ces structures correspondrait ainsi à un cerveau hérité d’ancêtres reptiliens, siège des comportements primaires, tandis que les deux autres, développés plus récemment, seraient dédiées d’une part aux émotions et, d’autre part, à la cognition.

Bien que la théorie ait rapidement été considérée comme erronée par la communauté scientifique, elle n’en a pas moins connu une grande popularité auprès du public, qui persiste encore à ce jour. Cette affirmation, qui n’est pas fondée scientifiquement, a été largement reprise et diffusée. Sébastien Lemerle (Université Paris Nanterre) montre avec les outils de la démarche sociologique que cela vient de contraintes, internes et externes, propres à la vulgarisation scientifique.

Lemerle S., Cerveau reptilien. Sur la popularité d'une erreur scientifique, Paris, CNRS éditions, 2021.

Du patrimoine commun à la marchandisation de la connaissance

- Détails

- Écrit par : Patrick Juignet

Une partie du monde académique met à disposition ses productions en accès libre. Parallèlement, le financement des recherches académiques par des entreprises, l’implication de celles-ci dans les formations universitaires, le dépôt de brevets, l’économie de l’édition et de la formation tendent à placer l’enseignement et la recherche dans une économie marchande avec des contraintes spécifiques. Le mélange de gratuité et de monétarisation, de partage et de marchandisation, d’altruisme et d’individualisme, est-il nécessaire au fonctionnement de la science actuelle ou pénalisant ? Quel modèle d’économie de la connaissance est le plus profitable à tous ? La science « ouverte » est-elle un partage ou la mise à disposition à bas coûts des productions scientifiques ?

Du patrimoine commun à la marchandisation de la connaissance

Les vidéos du séminaire 2019-20121 sur les faits sont disponibles. La remise en cause de « faits » établis dans le monde académique pose la question des critères de validation et des méthodes d’établissement des faits. Y a-t-il une méthode universelle pour dire ce qui est vrai ou chaque discipline a-t-elle ses propres critères spécifiques pour décider des limites des énoncés acceptables ? Est-ce que la façon d’établir les faits ou la manière de les énoncer a changé ? Nous souhaitons faire le point sur ce qu’est un fait établi dans différentes disciplines. A travers l’organisation d’une série de séminaires dans différentes disciplines, le séminaire itinérant du Centre d’Alembert permettra d’interroger la légitimité et la fécondité du doute ainsi que ses limites à l’heure des « faits alternatifs » et des manipulations de l’information sur des sujets traités dans le monde académique.

Qu'est-ce qu'un fait établi ? Comment se trompe-t-on ?